Un robot tueur abat un sniper : vers l’arme du futur de la police ?

Tout a commencé avec la mort d'un Afro-Américain, tué par des policiers. La vidéo, relayée sur les réseaux sociaux, a à nouveau pointé du doigt les morts raciales aux Etats-Unis, et provoqué des émeutes sous le slogan "Black Lives Matters", avant que cela ne dégénère avec des tirs de snipers visant les policiers. Finalement, un robot a été envoyé afin d'abattre le suspect. A présent, une nouvelle question se pose : "à quel point peut-on se fier aux robots pour accomplir le travail d'un être humain ?"

Une première utilisation "civile"

Si il s'agit de la première fois qu'un robot est chargé de faire le travail de la police, dans ce genre de cas, son utilisation est très répandue dans l'armée. En effet, les troupes basées en Irak ont déjà recours à ce genre d'artifice, en usant d'un robot nommé Marcbot, afin d'éliminer des cibles bien trop dangereuses pour y envoyer des soldats.

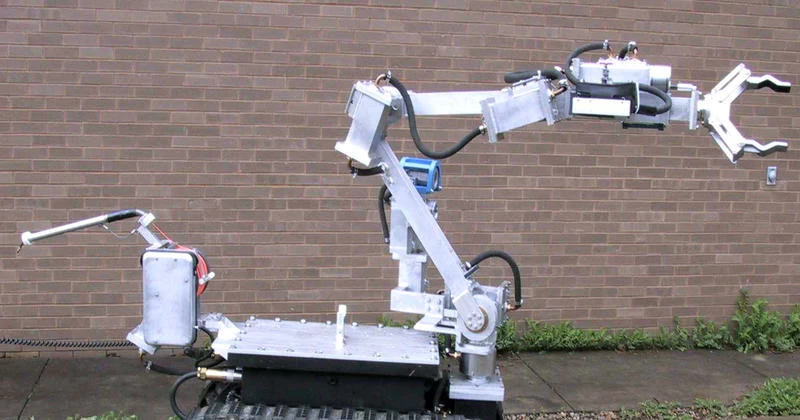

Il ne s'agit pas, toutefois, d'un robot de ce type qui a abattu Micah Johnson, la personne suspectée d'avoir tiré sur les policiers et d'avoir placé des explosifs dans la ville. Il s'agit plutôt d'un Northrop Grumman Andros, qui est plutôt destiné à désarmer les véhicules piégés notamment. Mais il s'agit de la première fois que l'un de ces robots est utilisé ainsi.

En Chine, un robot anti-émeute appelé AnBot fait déjà polémique, en raison de l'intégration d'un outil anti-émeute électrisé, entendez par-là une sorte de taser, ne pouvant être déclenché que par les personnes contrôlant AnBot

China's 1st intelligent security robot debuts; can patrol autonomously, protect against riot https://t.co/QjjQr7qxhI pic.twitter.com/B45noU1bHJ

— People's Daily,China (@PDChina) 26 avril 2016

Ethique et robotique

Vous l'aurez compris, cela pose le problème de la responsabilité des robots dans le cadre de certaines actions, notamment de police. Ces derniers étant programmés pour réagir précisément en fonction de la menace, ils risquent de contrevenir à la première loi de la robotique telle qu'énoncée par Isaac Asimov :

"Un robot ne peut porter atteinte à un être humain, ni, en restant passif, permettre qu'un être humain soit exposé au danger"

Et ce, en raison du fait qu'ils ne peuvent ressentir les émotions humaines. A l'instar des algo-rédacteurs, ils ne peuvent pas ressentir d'empathie quelconque et émettre un véritable jugement sur les actes des personnes se trouvant en face d'eux, car ils sont incapables d'appréhender l'esprit humain.

La réaction sera celle prévue par son codage informatique, et non pas le résultat d'une véritable décision humaine. En fin de compte, elle s'apparentera plus à une réaction instinctive de l'être humain. Or, il s'agit de ce genre de réactions qui sont actuellement reprochées à la police américaine.

Pour résoudre un dilemme type : si ne pas neutraliser une personne dangereuse par respect pour sa vie, c'est laisser cette personne agir et mettre en danger la vie d'autres, il y a bien plus de trois lois et nombre de modifications à aux quatre primaires (n(oublions pas la zéro), ainsi que des redéfinitions de termes, ce qui ultimement revient à de la programmation.

Une programmation qu'il tend à expliquer comme étant proche de l'éducation d'un individu, et donc que s'interroger sur le danger que représente un robot équivaut à s’interroger sur le danger que représente un individu, que ce soit parce que ce robot est programmé par un individu ou parce que au stade summum de l'intelligence artificielle le robot devient conscient et est capable de se programmer et se reprogrammer seul.

Lisez les oeuvres plutôt que de prendre bêtement au pied de la lettre une idée erronée qui est mâchée depuis bien trop longtemps déjà.

Si l'homme tué était dangereux c'est "bien" de voir qu'il y a des moyen de ne pas risquer bêtement la vie d'un flic, sachant qu'on parle peu souvent des nombres de policiers tué sur le terrain.

le robot est télécommandé par un opérateur. il n'y a pas d'IA dans ce robot donc la question des loi d'isaac asimov ne s'applique pas.

c'est une arme télécommandé pas un robot a la i-robot