Les premiers robots capables de désobéir sont là

En général, lorsque l'on pense au robot, on pense tout de suite à des êtres obéissants et capables d'aider l'espèce humaine dans les tâches les plus ardues. Enfin, si on met de côté iRobot, Matrix ou Futurama. Une obéissance qui pourrait changer avec le projet de ces deux chercheurs de l'université de Tufts dans le Massachusetts.

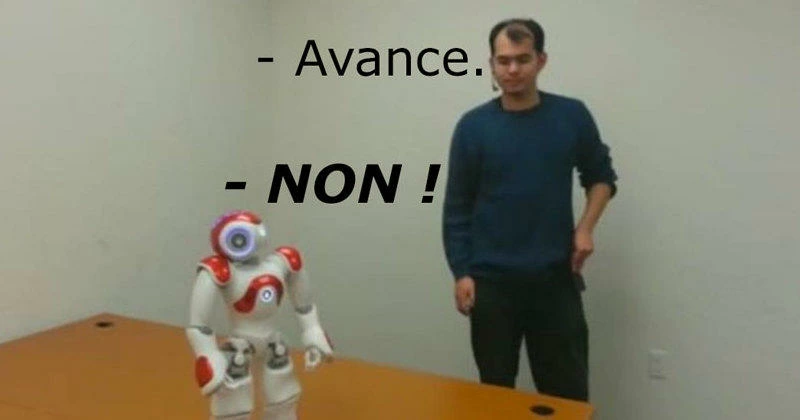

Quand on lui demande de s'asseoir ou de se lever, le robot suit les ordres, sans broncher. Mais si on lui demande d'aller tout droit vers le vide, il refuse. Poliment, certes, mais il refuse quand même. Gordon Briggs et Matthais Scheutz sont les scientifiques à l'origine du projet. Leur objectif est d'humaniser les robots et non d'en faire des machine à tuer comme on pourrait le croire.

Dans leur article, présenté à l'Association pour l'Avancement de l'Intelligence Artificielle, ils écrivent qu' "il y a une communauté grandissante qui s'intéresse à l'éthique pour les machines, où l'autonomie des robots vis-à-vis de leurs propres actions permet de raisonner sur le plan éthique". Voici une autre vidéo où un de leurs robots choisit de ne pas suivre une instruction.

Pour cette expérience, deux robots ont été utilisés, Shafer et Dempster. Les ingénieurs ont implémenté un résonnement mécanique dans le software des machines. Une fonction leur permettant d’analyser l’environnent et de savoir si une action peut compromettre leur sécurité. Une prise de conscience de soi qui ressemble à la graine de la désobéissance.

Mais la désobéissance n'est pas non plus aveugle. En effet, les humanoïdes refusent d’obéir non pas par flemme, mais simplement parce que les ordres peuvent entrer en contradiction avec leur propre sécurité. La troisième Loi de la Robotique d'Isaac Asimov est donc toujours respectée.

En dépit de tous les blockbusters où l'on voit des robots désobéir aux humains, avec des conséquences désastreuses, on se dit que cette idée peut être un poil dangereuse. Surtout avec la prévision selon laquelle, les humains seront moins intelligents que les robots dès 2029.

On ne peut pas deduire des ecris d'auteur de SF qu'il se passera exactement les meme problemes.

Apres j'avoue ne pas etre particulierement a l'aise avec cette innovation.

Si il faut, nous ne faisons que accélérer la théorie de l'évolution

C'est juste une autre expression de notre côté autodestructeur

dans le cas present, si c'est pour eviter les ordres stupides, c'est la moindre des choses

Donc au contraire, il obéit parfaitement, et applique à merveille le protocole rentré...

Pendant mes études, je n'ai eu aucun mal à faire un programme qui résoud les sudoku. Comment j'ai fait ? J'ai reproduit en algorithme notre façon de résoudre un sudoku.

Après tout, quand tu réfléchis, tu mets en relation un ensemble de faits (actuel et par rapport à ton vécu, un ensemble de données en gros) pour en ressortir une logique qui n'a rien de métaphysique.

On est pas dans la bible, nous ne sommes que des machines biologiques...

Personnellement la vrai prise de conscience je pense qu'elle se fait à partir du moment ou tu sais que te jeter dans le vide va à l'encontre de protéger ton existence mais que cependant tu as toujours le choix de le faire ou non.

Là le robot est programmé pour repérer du vide et donc obligatoirement ne pas y aller. Là l'bordel il a autant de conscience qu'un capteur de sécurité.

Votre conclusion est erronée.

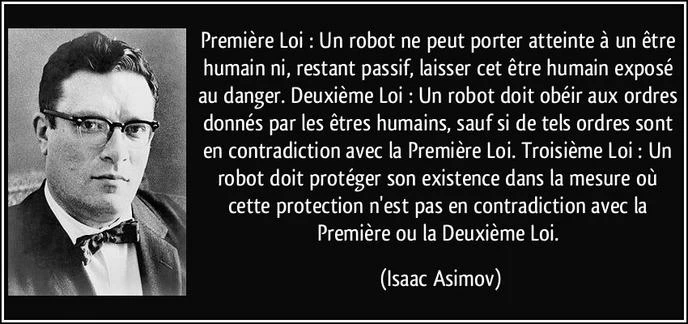

Rappel des trois lois :

1 Un robot ne peut porter atteinte à un être humain, ni, en restant passif, permettre qu'un être humain soit exposé au danger ;

2 Un robot doit obéir aux ordres qui lui sont donnés par un être humain, sauf si de tels ordres entrent en conflit avec la première loi ;

3 Un robot doit protéger son existence tant que cette protection n'entre pas en conflit avec la première ou la deuxième loi.

On dit au robot "tu sautes" (loi 2), ça n'entre pas en conflit avec la première loi si dans la situation il ne met pas en danger un être humain.

S'il ne saute pas, il viole la loi 3 puisqu'on lui a donné un ordre direct et valide (loi 2), et qu'il ne le fait pas.

Et puis marcher dessus ça peut être dangereux !

Ici le refus un programmé et non venant du robot lui meme.

Je vois pas où c'est terrifiant.